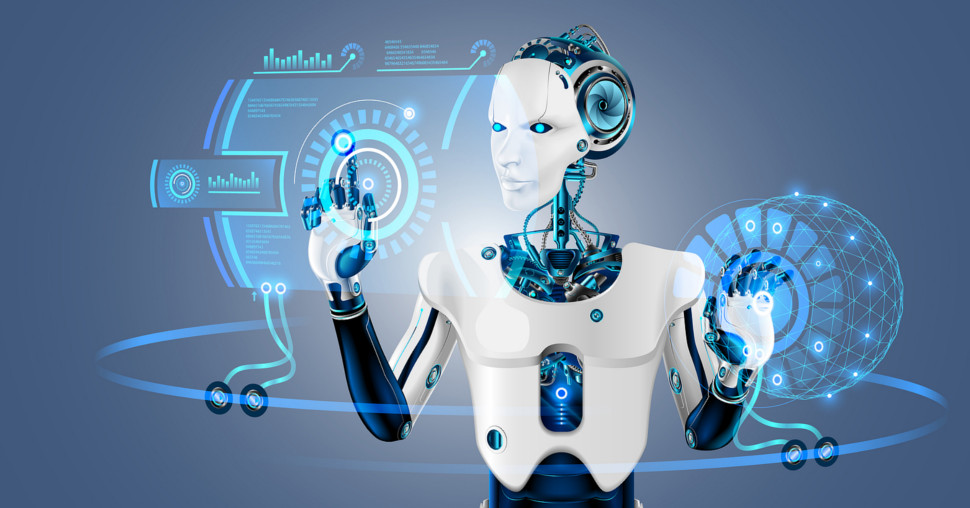

Roboti konačno uče kako da pomeraju usne poput ljudi

Roboti imaju problem sa nečim o čemu ljudi gotovo i ne razmišljaju - pokretima usana. Gotovo polovina naše pažnje u razgovoru licem u lice usmerena je na to kako se sagovornikova usta pomeraju.

20-01-2026

|11:22

|Autor / Izvor: Naxi media, Earth.com, Science Robotics

To je ogroman deo moždane energije potrošen na mali deo lica. Zbog toga video-poziv sa lošim zvukom deluje neprirodno ili osoba koja ne može dobro da pomera lice može izgledati „teško čitljiva“, čak i kada govori prave reči.

Roboti se sa tim problemom sudaraju direktno. Robot može da hoda, podiže predmete i čak odgovara na pitanja – ali ako mu pokreti usana ne prate glas, ljudi postaju nelagodni. Spremni smo da robotima oprostimo ukočen hod ili nespretne ruke, ali ne i lice koje izgleda gotovo ljudski, ali ne sasvim. Taj fenomen poznat je kao „jeziva dolina“ (uncanny valley).

Zašto su usne poseban izazov za robote?

Realistična usta nisu samo vilica koja se otvara i zatvara. Ljudski govor sastoji se od sitnih zvučnih jedinica, a svaka ima tačno određene obrasce pokreta usana i precizno tempiranje.

Usne se istežu, pritiskaju, uvijaju i opuštaju u brzim nizovima, usklađene sa obrazima, vilicom i regijom oko usta. Naš mozak primećuje i kašnjenje od svega delića sekunde.

Zbog toga mnogi humanoidni roboti deluju beživotno ili čak jezivo. Čak i oni najskuplji često koriste ono što istraživači nazivaju „muppet“ pokretima usta - grube, lutkarske pokrete.

Ako robot uopšte ima lice, ono je obično rigidno. Pokreti su unapred isplanirani, poput predstave sa lutkama, umesto da se prirodno prilagođavaju zvuku koji robot proizvodi.

Robot koji je učio posmatrajući sopstveno lice

Tim sa Columbia Engineering razvio je robota koji može da nauči pokrete usana za govor i pevanje.

Istraživači su prikazali robota kako govori na više jezika i peva pesme sa svog AI debitantskog albuma „Hello World“.

Ključ je u načinu na koji je učio. Umesto da mu se unapred zadaju pravila o tome koji motor treba da se pomeri za koji glas, robot je učio posmatranjem.

Najpre je upoznao sopstveno lice. Istraživači su postavili robotsko lice sa 26 motora ispred ogledala i dozvolili mu da eksperimentiše.

Robot je napravio hiljade nasumičnih izraza i pokreta usana, a zatim povezao ono što vidi sa onim što radi. Ovaj pristup naziva se „vision-to-action“ jezički model (VLA).

Nakon toga, robot je proučavao ljude. Gledao je sate YouTube snimaka na kojima ljudi govore i pevaju, što je veštačkoj inteligenciji omogućilo da uoči kako se prava usta kreću pri određenim zvucima.

Kombinacijom ta dva procesa, sistem je mogao da prevede zvuk u precizne motorne pokrete usana, sinhronizovane sa govorom.

Šta robot sada može?

Tokom testiranja, robot nije morao da razume značenje audio-snimaka. Njegov zadatak bio je samo da uskladi pokret sa zvukom - bez obzira na glas, jezik ili čak pesmu.

To je važno jer razdvaja ritam govora od razumevanja jezika. Robot, barem u teoriji, može prvo da nauči fizičku dinamiku govora, a tek kasnije i značenje reči.

Istraživači ipak ističu da rezultati još nisu savršeni. Profesor Hod Lipson, direktor Creative Machines Lab-a na Kolumbija univerzitetu, navodi:

„Imali smo posebne poteškoće sa tvrdim glasovima poput ‘B’ i sa zvucima koji uključuju skupljanje usana, kao što je ‘W’. Ali očekujemo da će se ove sposobnosti vremenom i vežbom poboljšati.“

To se uklapa u ono što već znamo o sistemima koji uče - što više primera imaju, to su bolji u retkim i zahtevnim slučajevima.

U govoru su upravo ti slučajevi najteži: brze promene i glasovi koji zahtevaju precizan kontakt usana, poput trenutka kada se usne potpuno zatvore, pa naglo otvore.

Nedostajuća karika u odnosu ljudi i robota

Ispravno pomeranje usta nije važno samo da roboti izgledaju manje neprijatno. Ključno je za komunikaciju. Ljudi se u velikoj meri oslanjaju na izraze lica kako bi procenili da li je neko prijateljski nastrojen, dosadan, šaljiv ili ozbiljan.

Lice takođe signalizira kada je red na drugu osobu da govori. Takvi signali su važni u učionicama, bolnicama, na šalterima za korisnike - svuda gde bi roboti mogli da rade među ljudima bez izazivanja nelagode.

„Veliki deo humanoidne robotike danas fokusiran je na pokrete nogu i ruku, poput hodanja i hvatanja“, kaže Lipson. „Ali izrazi lica su jednako važni za svaku robotsku primenu koja uključuje interakciju sa ljudima.“

Juhang Hu, koji je predvodio studiju tokom doktorskih studija, povezuje lice robota sa savremenim čet-sistemima koji već dobro vode razgovore.

„Kada se sposobnost sinhronizacije usana kombinuje sa konverzacionom veštačkom inteligencijom poput ChatGPT-a ili Geminija, efekat daje sasvim novu dubinu vezi koju robot gradi sa čovekom“, objašnjava Hu.

„Što robot više posmatra ljude u razgovoru, to će bolje imitirati suptilne izraze lica sa kojima se emocionalno povezujemo.“

Budućnost humanoidnih robota

Prema Huovim rečima, što je kontekst razgovora duži, to će i gestovi postajati osetljiviji na situaciju.

Ako humanoidni roboti postanu uobičajeni, pritisak da deluju prirodno samo će rasti. Tim navodi da neki ekonomisti predviđaju proizvodnju više od milijardu humanoidnih robota u narednoj deceniji. To nije marginalna budućnost – to je svet u kojem će se lica mašina pojavljivati svuda, a ljudi će ih procenjivati u roku od nekoliko sekundi.

„Ne postoji budućnost u kojoj svi ti humanoidni roboti nemaju lice. A kada ga budu imali, moraće pravilno da pomeraju oči i usne, ili će zauvek ostati u jezivoj dolini“, procenjuje Lipson.

„Mi ljudi smo jednostavno tako povezani i ne možemo protiv toga“, dodaje Hu. „Blizu smo prelaska preko jezive doline.“

Kompletna studija objavljena je u časopisu Science Robotics.